A OpenAI está se movendo para publicar os resultados de suas avaliações internas de segurança de modelo de IA mais regularmente no que a roupa está lançando como um esforço para aumentar a transparência.

Na quarta -feira, o Openai lançou o Hub de avaliações de segurançauma página da web mostrando como os modelos da empresa marcam em vários testes para geração de conteúdo prejudicial, jailbreaks e alucinações. O OpenAI diz que usará o hub para compartilhar métricas de forma “contínua” e que pretende atualizar o hub com “principais atualizações de modelo” daqui para frente.

“À medida que a ciência da avaliação da IA evolui, nosso objetivo é compartilhar nosso progresso no desenvolvimento de maneiras mais escaláveis de medir a capacidade e a segurança do modelo”, escreveu o OpenAI em um Postagem do blog. “Ao compartilhar um subconjunto de nossos resultados de avaliação de segurança aqui, esperamos que isso não apenas facilite o entendimento do desempenho de segurança dos sistemas OpenAI ao longo do tempo, mas também apoie os esforços da comunidade para aumentar a transparência em todo o campo”.

O Openai diz que pode adicionar avaliações adicionais ao hub ao longo do tempo.

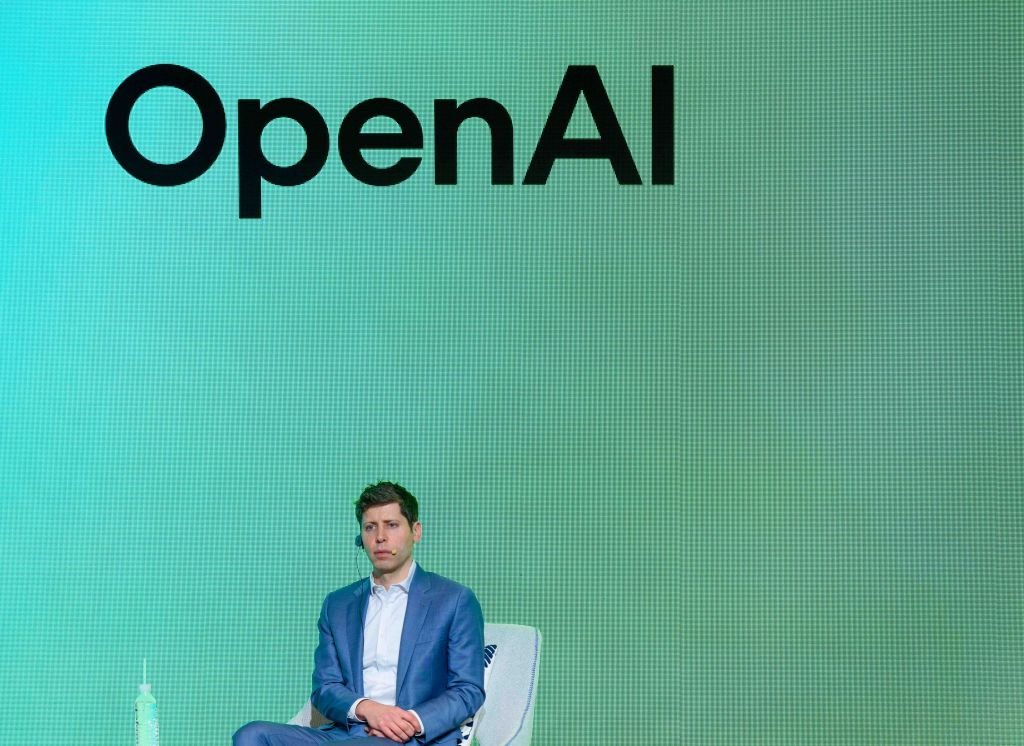

Nos últimos meses, o OpenAI aumentou a ira de alguns ética para segundo apressando o teste de segurança de certos modelos emblemáticos e não liberando relatórios técnicos para outros. O CEO da empresa, Sam Altman, também fica acusado de enganar os executivos do OpenAI sobre as revisões de segurança do modelo antes de seu breve deposição Em novembro de 2023.

No final do mês passado, o OpenAI foi forçado a reverter uma atualização Para o modelo padrão que alimenta ChatGPT, o GPT-4O, depois que os usuários começaram a relatar que ele respondeu de uma maneira excessivamente validada e agradável. X Tornou -se inundado com capturas de tela de chatgpt aplaudindo todo tipo de problemático, perigoso decisões e idéias.

Openai disse que faria implementar Várias correções e alterações para impedir futuros incidentes, incluindo a introdução de uma “fase alfa” de inscrição para alguns modelos que permitiriam que certos usuários do ChatGPT testassem os modelos e forneçam feedback antes do lançamento.